具備情境理解能力的個人助理機器人研究進展

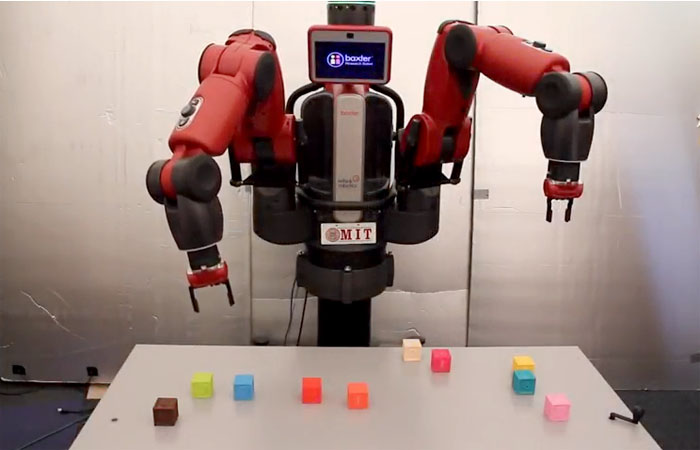

圖片來源: Baxter robot: http://news.mit.edu/2017/robot-learns-to-follow-orders-like-alexa-0830

儘管語音交互正像觸控式螢幕那樣為數位介面帶來重大變革,但語言處理有其局限性。特別是,數位語言處理僅限於有限且特定的指令,尚未具備人類對話中的情境理解能力。

在相關領域的前沿研究中,麻省理工學院(MIT)電腦科學與人工智慧實驗室(CSAIL)的研究人員致力於構建一個更好的處理單元,使機器人不需要循序漸進的指令,而是可以從指令和語境中的上下文來對事物進行推斷。

因此,“ComText”誕生了,這是一個處理系統,代表“上下文中的指令”,使機器人可以理解聊天背景資訊,如語言線索和周圍環境。

為什麼上下文很重要?

在自然語言的使用中,經常說類似於“把它撿起來”這樣的話。雖然人類能夠根據情境來理解這裡的“它”指的是什麼,但如今的數位化助手或機器人需要更多的資訊才能夠理解,因為指令缺乏特定性。

MIT 解釋說:“撿起它意味著能夠看到並識別物體,理解指令,識別出問題中的“它”指的是你放下的工具,回到你放下手中工具的記憶中,並將你放下的工具與其他類似形狀和尺寸的工具區分開來。”

目前,像Alexa和Siri這樣的數位化助手正在徹底改變我們與科技互動的方式,但要讓機器人個人助理不斷發展,這種對於情境的理解能力是必不可少的。

ComText的實際應用:語言處理

ComText的實際應用:空間理解

挑戰

RAGE Frameworks的首席執行官 Venkat Srinivasan 認為這種交互的挑戰主要有三點。

首先,許多支援語音的人工智慧工具,比如IBM Watson和Google AlphaGo,在處理人類語言方面存在困難,因為“當前大多數應用是將文本視為資料,而不是語言”。

第二點是情境理解:“只有當技術專注於語言結構,而不是像目前大多數技術所做的那樣僅僅注意文本中的單詞時,才能進行正確的情境理解。”

最後一個挑戰是邏輯:使用這個解決方法得出的結論,其推理之間的可追溯性。

“情境學習”的研究與發展

根據這篇研究論文,為了研發ComText,一個研究團隊使用了“強化自然語言的概率模型”。

“主要貢獻在於告訴了我們機器人應該像人類那樣有多種類型的記憶,” 首席研究員Andrei Barbu表示,“我們有了解決這個問題的第一個數學公式,現在正在探索這兩種類型的記憶是如何相互配合並發揮作用的。”

為了測試這個工具,研究者使用了一個名叫Baxter Research Robot(百特研究機器人)的雙臂人形機器人,在頻率∼20Hz、解析度1080×760的條件下,使用交叉校準的Kinect 2版 RGB-D觀察工作區。配置有一個Amazon Echo Dot(亞馬遜回聲點),可以將語音指令轉換為文本。

為了研究該機器如何有效地對上下文線索進行評估,要求獨立操作的人員直接指示機器人完成五項任務,最後製作了96個用戶與機器人交互的短視訊。透過對視訊進行分析,研究者發現在90.2%到94.7%的時間,推斷出的命令以“在目標位置,對正確的物品執行正確的操作”的方式被執行。

發生失敗主要是由於感知錯誤,或由於障礙物遮擋了視線,或因為物體直接朝向或遠離相機的行動。

這個實驗成功的證明了ComText從傳統的語言陳述中搜集線索,並將它們與視覺觀察相結合,然後對行動物體進行追蹤的能力。隨著時間的推移,透過更多的交互和觀察,這些積累起來的經驗也會被逐漸細化。

個人助理機器人的潛在應用

雖然關於AI倫理問題的偏見仍然存在,但ComText在發展成為具有更接近“人類交互能力”的機器人方面依然取得了重大進展。不過,現實情況是,要實現一個能理解人類互動細微差別全功能助手機器人,我們還有很長的路要走。

首席研究員Rohan Paul表示:“目前,我們還沒有生產產品。” 與之相對的是,他們仍然堅持如何在機器搜集更大範圍的上下文資訊並得出結論的能力方面得到提高,Paul說:“我們真正想做的是讓人類和機器人的能力相結合,一起來創造出更複雜的東西。”