機器人、人工智慧以及所引起的倫理道德問題

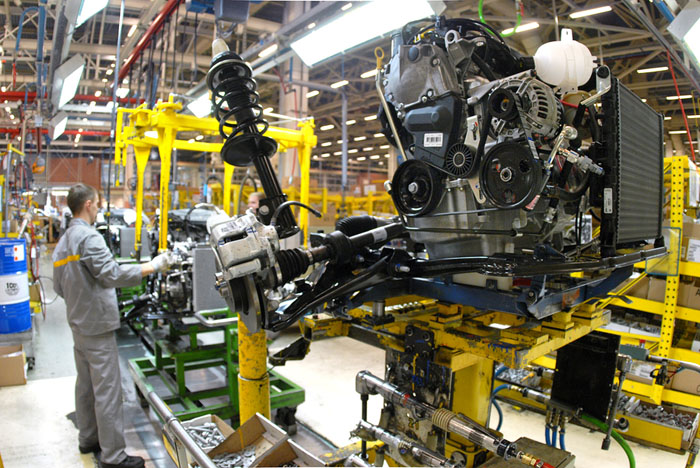

機器人技術和人工智慧(AI)的最新進展可以透過龐大資料集的快速分析和尋常任務的自動化、欺詐檢測以及物流的改善來最佳化工作場所。

機器人技術和AI技術還可以透過外包危險工作使工作場所更加安全。隨著這些技術的發展,人類的生活有望變得更有效也更有意義,因為我們將有時間專注於更重要的任務。

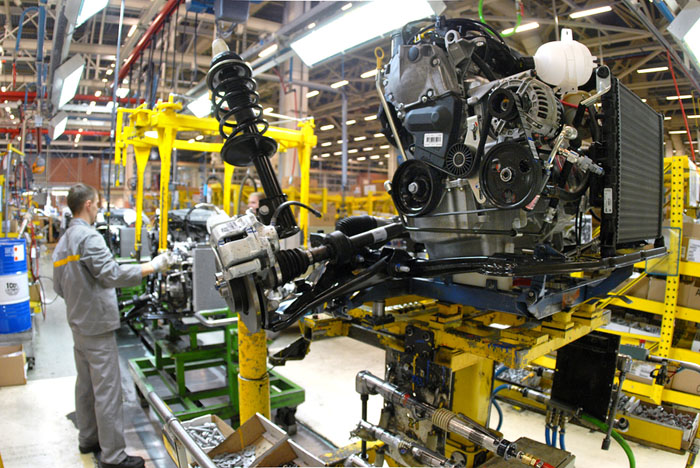

工廠裝配線上新製造的發動機

由於這個領域的發展日新月異,技術領導者和學者們開始著重強調進行徹底的道德和風險評估。雖然每種新技術都伴隨著風險因素,但是人類社會中的智慧演算法和機器人技術帶來的關注遠不止資料收集和隱私。實際上,它們帶來的是在為時已晚之前,我們的社會需要解決的道德問題。

如果失業了,那麼可能帶來的不平等將走向何方?

隨著更多工作實現自動化,人們將會承擔更為複雜的角色。這在我們從密集型體力勞動工作轉向更多認知角色時已有諸多比較。

但是,這並非如此簡單!

例如,特斯拉首席執行官Elon Musk承諾在不久的將來將提供自動駕駛卡車。如果自動駕駛卡車在全國範圍內被廣泛採用,那麼社會體系就需要適當地讓卡車司機無縫暫態到更有意義的角色。

目前,多數家庭透過交換時間來維持自己的可持續收入,因此這種轉變可能會創造一種後工作社會。雖然可以希望這些個人能夠找到更有意義的工作,但是這尚無明顯跡象可循。

確實,技術可以讓我們騰出時間從事更有意義的工作、與家人共度時光、照顧親人,但是我們仍然無法確定被這項技術取代的工人是否具備必要的技能,來找到替代的收入來源。

我們目前的經濟是基於對貢獻模式的補償(許多工人按小時支付)。因此,如果我們不開始重新構想和重組我們的經濟以在不久的將來維持後工作社會,那麼AI技術和機器人技術將有可能迅速加劇不平等的產生。

忽視這些影響會產生極其嚴重的後果。當人們試圖在這個新世界中生存時,不平等可能迅速滋生犯罪、暴力和一般混亂。

AI偏見和錯誤的後果是什麼?

當AI積極地從演算法中學習時,就有可能會產生真實的危險後果。例如,在歷史事件中,由Hanson Robotics研發的人形機器人Sophia被授予沙烏地阿拉伯公民身份。

然而,也是這個機器人在去年的西南偏南(SXSW)技術展期間在演示時遇到了技術故障。當人們開玩笑地問她是否會摧毀人類時,她竟回答:“好的,我將摧毀人類”,這令人驚愕不已。

此外,根據一項分析2001年到2010年編輯維基百科文章的機器人之間的交互的研究,雖然機器人旨在支援百科全書,但是機器人經常會撤銷彼此的編輯且在數年內爭論不休。

與平台上的人工交互相比,機器人的交互時間會更長久且會翻來覆去。與人類一樣,機器人在不同文化環境中的表現也不盡相同,甚至最基本的機器人也能夠進行複雜的交互。

研究影響機器人間交互的因素以及為新的創新研發適當的網路安全至關重要。

除了潛在的故障和攻擊之外,系統還可能犯其它錯誤。不管AI根據其輸入如何學習和檢測正確的模式,訓練階段絕對無法涵蓋系統在現實世界中可能必須處理的每個可能的案例。

無論多麼聰明,這些系統仍然可能以人類不會經受的方式被愚弄。因此,如果在勞動力隊伍中應用人工智慧系統,那麼也應當建立適當的機制來確保不會產生偏見,也不會讓人類為了自己的目的而壓制和利用它。

如果機器人和AI系統遭到破壞怎麼辦?

當勒索軟體攻擊成為常態時,預計很有可能發生對機器人和AI系統的攻擊。如果我們繼續用機器人和自主武器取代士兵,那麼這些機器人和自主武器就有可能被犯罪分子和流氓政府控制。這使得網路安全對於機器人和AI系統而言都至關重要。即使這項技術不是為戰爭而研發的,工廠機器人和自動駕駛汽車也有可能被破壞並被用作對付我們的武器。

因此,在社會迅速應用並融入這項技術之前,我們必須首先找到構建不會被破壞的系統的方法。但是我們將處理就數量級而言比我們更強大、更快的系統。實現堅不可摧的網路安全近乎是不可能的。

機器人技術和AI技術的發展已經有目共睹。政府、企業、學術界和公眾將透過積極尋找有道德的、穩步前行的方法來得到最佳服務。這意味著要為潛在的後工作社會研發新的收入模型、研發替代技能的資源、對機器人交互的深入理解、制定有效對應系統內故障的協定、以及制定安全性更優異的穩健計畫。